Zada, Hedron Grinder

Data Level Parallelism

Comment fait Ducobu pour faire plus vite ses punitions ?

Il utilise le fameux « crayon multi-ligne » !

Et bien il fait du SIMD :-)

N.B. : marche aussi avec un pinceau et un mur…

Illustration

X | [ x_0 | x_1 | x_2 | x_3 ] + | + + + + X | [ y_0 | y_1 | y_2 | y_3 ] = | = = = = Z | [ z_0 | z_1 | z_2 | z_3 ]

Single Instruction Multiple Data

Les processeurs classiques travaillent sur des scalaires. Les processeurs vectoriels travaillent sur des vecteurs:

Le temps d'exécution d'une opération sur un scalaire ou un vecteur est du même ordre de grandeur.

Il faut pouvoir transférer (charger ou décharger) les données depuis la mémoire vive vers les registres vectoriels.

Historique (dangerous)

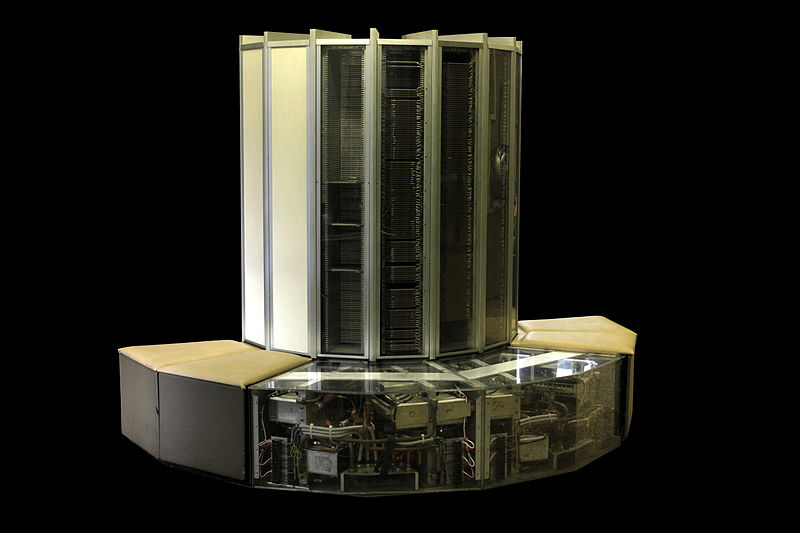

le Cray-1 (né en 1975, 1m96...)

- le premier dans une puce grand public: Pentium MMX en 1996

- puis généralisé avec les jeux d'instructions SSE1-2-3-4-5 (1999, PIII), AVX (2008) sur 128 bits , AVX2 sur 256 bits (2011) et AVX-512 (32 registres sur 512 bits, apparu en 2013 sur les coprocesseurs Xeon Phi, 1 registre = 16 double ou 32 single !)

- concurrencé un temps par IBM-Motorola/Altivec (sur la gamme PowerPC)

- Sur ARM: Neon, avec différentes extensions (p.e. i8mm)

exemple d'architecture: les coeurs de XeonPhi

Ce que l'on trouve dans une documentation Intel sur le Xeon Phi

Exemple d'architecture: les coeurs de XeonPhi

Et quand on creuse (pas trop profond) dans le silicium encore chez Intel

Les instructions vectorielles ont une latence supérieure à celle des instructions scalaires mais le même débit d'instruction!

Merci le pipeline !

Il y a un accès partagé au cache L1 et L2: attention aux interférences!

Merci le pipeline !

Merci le pipeline !

Merci le pipeline !

La fameuse Vector unit:

Contrat Matériel

Les architectures matérielles offrent de la performance mais à condition de respecter des contraintes de bon fonctionnement de ce matériel:

- gestion du cache (alignement des données, pre-fetch),

- gestion de la latence (variable! Sur Xeon Phi Gen2: la plupart des opérations en floating-point ont une latence de 6 cycles alors que les autres opérations ont une latence entre 2 et 3 cycles.),

- bonne utilisation des registres (travailler en place si possible),

- conscience de la fréquence processeur potentiellement plus faible (fréquence AVX-512 sur Core I9 inférieure pour limiter la chauffe)

Dans votre ThinkPad / Lenovo / Asus

$ grep flags /proc/cpuinfo flags : ... mmx ... sse4_1 sse4_2 ... avx avx2 ...

Dans votre carte de Gamer

Assassin's creed VALHALLA - PC Specs

Minimum Recommended High Enthusiast Ultra GPU GTX960 GTX1060 GTX1080 RTX2080S RTX2080

Source: Ubisoft

Dans les centres de calcul

https://www.top500.org/, November 2023

Instructions SIMD, Vues du C

Les intrinsèques supportés par la majorités des compilateurs, par famille de jeu d'instruction

#include <immintrin.h> for(float *iter0 = ptr0, *iter1 = ptr1; iter0 < end0; iter0 += 16, iter1 += 16) { __m256 v0 = _mm256_loadu_ps(iter0); __m256 v1 = _mm256_loadu_ps(iter1); dot0 = _mm256_fmadd_ps(v0, v1, dot0); _mm256_storeu_ps(iter0, dot0); v0 = _mm256_loadu_ps(iter0 + 8); v1 = _mm256_loadu_ps(iter1 + 8); dot1 = _mm256_fmadd_ps(v0, v1, dot1); _mm256_storeu_ps(iter1, dot1); }

Instructions SIMD, Vues du C

Avantages :

- Contrôle grain fin, proche de l'assembleur (~1 intrinsèque par instruction assembleur)

- Typage fort

Inconvénients :

- Portabilité nulle

Bible Intel sur le sujet: https://www.intel.com/content/www/us/en/docs/intrinsics-guide/index.html

🎮 Jeu !

Corrigez le code suivant en utilisant les bons intrinsèques:

https://godbolt.org/z/M7xcs4xK3

#include <immintrin.h> #include <cstdint> void toy(uint16_t *ptr0, uint16_t *ptr1, uint16_t *end0) { for(uint16_t *iter0 = ptr0, *iter1 = ptr1; iter0 < end0; iter0 += 30, iter1 += 30) { __m256i v0 = _mm256_loadu_si256((__m256i*)iter0); __m256i v1 = _mm256_loadu_si256((__m256i*)iter1); __m256i adds = _mm256_add_epi16(v0, v1); _mm256_store_si256((__m256i*)iter0, adds); } }

Commentez la sortie de l'outil llvm-mca sur cet exemple

Instructions SIMD, Vues du C++

Bibliothèque de portabilité, basées sur les intrinsèques et la méta-programation

for(size_t i = 0; i < vec_size; i += 2 * simd_size) { auto v0 = xs::load_aligned(&ptr0[i]); auto v1 = xs::load_aligned(&ptr1[i]); dot0 = xs::fma(v0, v1, dot0) dot0.store_aligned(&ptr0[i]); v0 = xs::load_aligned(&ptr0[i + simd_size]); v1 = xs::load_aligned(&ptr1[i + simd_size]); dot1 = xs::fma(v0, v1, dot1) dot1.store_aligned(&ptr0[i + simd_size]); }

Instructions SIMD, Vues du C++

Avantages :

- Contrôle grain fin, proche de l'assembleur (~1 intrinsèque par instruction assembleur)

- Typage fort

- Portabilité

Inconvénients :

- Ne couvrent généralement pas toute les possibilités du langage cible (prix de la généricité)

- Contrainte de langage (e.g. C++11)

🎮 Jeu !

Comparez avec la sortie du code suivant :

https://godbolt.org/z/nWPd1nxM6

#include <xsimd/xsimd.hpp> void toy(uint16_t *ptr0, uint16_t *ptr1, uint16_t *end0) { using b16_t = xsimd::batch<uint16_t>; for(uint16_t *iter0 = ptr0, *iter1 = ptr1; iter0 < end0; iter0 += b16_t::size, iter1 += b16_t::size) { auto v0 = b16_t::load_unaligned(iter0); auto v1 = b16_t::load_unaligned(iter1); auto adds = xsimd::sadd(v0, v1); adds.store_unaligned(iter0); } }

Changez l'architecture cible et observez le résultat en terme de performance et de portabilité.

Instructions SIMD, Vues de d'OpenMP

Annotation de code pour la vectorisation automatique de boucles

interface real function func(x) !$OMP DECLARE SIMD (func) real, intent(in) :: x end function func end interface vec_sum = 0. ! !$OMP SIMD reduction(+:vec_sum) do i = 1,nx vec_sum = vec_sum + func(x(i)) enddo

Compatible C, C++ et Fortran

Instructions SIMD, Vues de d'OpenMP

Avantages :

- Explicite

- Incrémental

- Portabilité

Inconvénients :

- Pouvoir d'expression limité

Instructions SIMD, Vues du Compilateur

ICC, Gcc, clang possèdent chacun des passes de vectorisation automatique. Il est alors nécessaire de préciser l'architecture ciblée :

- -march=native pour cibler la machine courante

- -mavx2 pour cibler AVX2

cf. -ftree-vectorize (gcc) -fvectorize clang, activés à -O2 ou -O3 suivant les compilos

Instructions SIMD, Vues du Compilateur

Avantages :

- Automatique

- Incrémental

- Portable

Inconvénients :

- Debug difficile

- Optimalité

🎮 Jeu !

Comparez la sortie de gcc et clang sur le code suivant :

https://godbolt.org/z/9eGbaGabv

#include <limits> #include <cstdint> void toy(uint16_t *ptr0, uint16_t *ptr1, uint16_t *end0) { for(uint16_t *iter0 = ptr0, *iter1 = ptr1 ; iter0 < end0; iter0 += 1, iter1 += 1) { uint32_t tmp = *iter0 + *iter1; if(tmp > std::numeric_limits<uint16_t>::max()) tmp = std::numeric_limits<uint16_t>::max(); *iter0 = tmp; } }

Changez le niveau d'optimisation, l'architecture cible... et comparez la sortie de llvm-mca sur ces différents cas.

Classification des opérations (1)

D'après le manuel ARM /Neon

- Bit manipluation (eg. vclzq_u8)

- Compare (eg. vcagt_f32)

- Complex arithmetic (eg. vcmlaq_rot180_f64)

- Cryptography (eg. vsha256hq_u32)

- Data Type Conversion (eg. vreinterpret_u8_s16)

- Load (eg. vld1q_dup_s32)

- Logical (eg. vornq_u16)

(...)

Classification des opérations (2)

(...)

- Move (eg. vmovl_high_s8)

- Scalar Arithmetic (eg. vmla_n_s32)

- Shift (eg. vshlq_u8)

- Store (eg. vst1q_s32)

- Table Lookup (eg. vqtbl1_u8)

- Vector Artihmetic (eg. vrecpsq_f32)

- Vector Manipulation (eg. vzip1q_u8)

🎮 Jeu !

Faites mieux que GCC sur le code suivant

https://godbolt.org/z/s8zP79K3T

#include <complex> void toy(std::complex<float> *ptr0, std::complex<float> *ptr1) { ptr0[0] *= ptr1[0] + 2.f; ptr0[1] *= ptr1[1] + 2.f; ptr0[2] *= ptr1[2] + 2.f; ptr0[3] *= ptr1[3] + 2.f; }

Astuces: -ffast-math, -O3, intrinsics, xsimd, lecture ... ?

Instructions SIMD : point-à-point

if-conversion perte de précision macro instructions permutations

Instructions SIMD, contraintes algorithmiques

On aime :

- Les structures régulières (pixels, tableau, matrices)

- Les algorithmes réguliers (boucles à pas fixe)

On aime moins :

- Les structures irrégulières (listes, arbres, graphes)

- Les algorithmes dynamiques (boucles à pas irréguliers, sauts conditionnels…)

🎮 Jeu !

Vectoriser le code dotprod.cpp en utilisant intrinsèques ou xsimd.

> clang -O2 dotprod.cpp -o dotprod -mavx2 -mfma > ./dotprod 10000

🎮 Jeu !

Vectoriser le code vmprod.cpp en utilisant intrinsèques ou xsimd.

> clang -O2 vmprod.cpp -o vmprod -mavx2 -mfma > ./vmprod 10000

Instructions SIMD, contraintes matérielles

Pour pleinement tirer parties des instructions SIMD, il est bon de

- Connaître (ou fixer) l'alignement de nos données

- Avoir des données contigües en mémoire

- Temps de chargement des données (prefetch)

SIMD vous fait rêver, mais réveillez-vous

Dans la vraie vie d'un code, il y a

- des successions de dépendances en série qui cassent le parallélisme,

- des opérations récursives à nombre de cycles variabeles (la division?),

- des données qui ne sont pas toujours disponibles à temps en cache L1 ou dans les registres,

- une mémoire RAM au débit limité et partagé, avec des ruptures possibles d'alignement,

- une puce qui chauffe et qui réduit sa fréquence de fonctionnement...

Aidons les outils

Mieux vaut

- écrire un code bien compréhensible par le compilateur que de finir le code à l'assembleur ou aux intrinsics (AVX-512 = environ 4000 instructions! Bon courage ;) ),

- savoir utiliser les bonnes bibiliothèques optimisées et coder des boucles "vectorisables":

- avec des profondeurs de boucles connues (pas de break, bof bof le while, attention aux tests "if" en cours de boucle),

- limitant les appels de fonctions (que du basique, passable en inline, issues de librairies "classiques"),

- avec des itérations indépendantes!!!